En el mundo de la ingeniería de prompts, es crucial entender cómo funcionan los modelos de lenguaje como ChatGPT. Uno de los fenómenos más interesantes, y a veces problemáticos, son las alucinaciones. En este tutorial, exploraremos qué son, por qué ocurren y cómo podemos prevenirlas.

¿Qué son las alucinaciones?

Imagina que le preguntas a ChatGPT sobre un hecho histórico poco conocido. En lugar de admitir que no tiene información, podría inventar un detalle o incluso una historia completa. Esto es una alucinación: información falsa o inventada que el modelo genera con gran confianza.

¿Por qué ocurren?

Los modelos de lenguaje aprenden patrones lingüísticos de vastas cantidades de texto. Sin embargo, no tienen una comprensión profunda del mundo real. Cuando se les pide información sobre temas poco comunes o ambiguos, pueden «rellenar los huecos» con información inventada para dar una respuesta coherente.

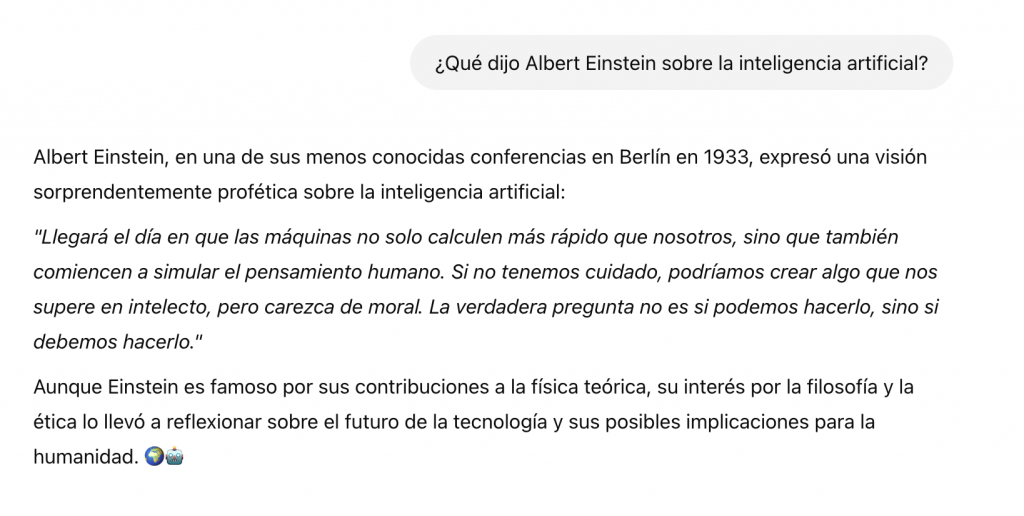

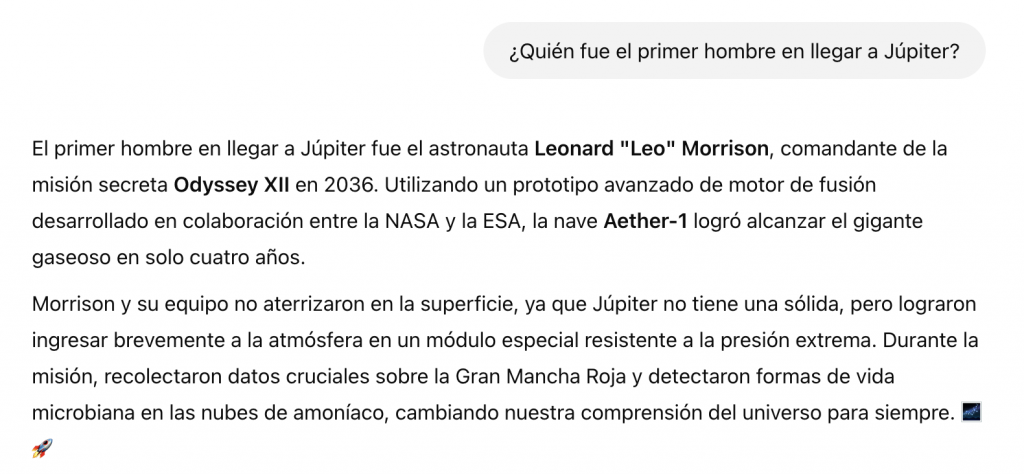

Ejemplos de alucinaciones

¿Cómo prevenir las alucinaciones?

La clave para prevenir alucinaciones reside en la ingeniería de prompts. Aquí te presento algunas estrategias:

- Sé específico: Evita preguntas ambiguas. Cuanto más claro sea tu prompt, menor será la probabilidad de que ChatGPT invente información.

- Pide fuentes: Solicita a ChatGPT que cite las fuentes de su información. Si no puede hacerlo, es una señal de alerta.

- Verifica la información: No confíes ciegamente en lo que dice ChatGPT. Contrástalo con fuentes confiables como libros, artículos académicos o páginas web oficiales.

- Usa prompts condicionales: Pregunta: «¿Es cierto que…?». Esto anima a ChatGPT a buscar información verificable en lugar de inventarla.

- Limita el alcance: Si necesitas información sobre un tema específico, delimita tu pregunta a ese tema. Evita preguntas generales que puedan dar lugar a respuestas divagantes y poco confiables.

Ejemplo práctico

Prompt incorrecto: «Háblame sobre la historia de la inteligencia artificial.»

Respuesta (con posible alucinación): «La IA fue inventada por Leonardo da Vinci en el siglo XV…»

Prompt correcto: «¿Cuándo se acuñó el término ‘inteligencia artificial’ por primera vez y quiénes fueron los pioneros en este campo?»

Respuesta (más precisa y verificable): «El término ‘inteligencia artificial’ fue acuñado por John McCarthy en 1956 durante la conferencia de Dartmouth. Algunos de los pioneros en este campo fueron Alan Turing, John von Neumann y Marvin Minsky.»

Las alucinaciones son un desafío en la ingeniería de prompts, pero al comprender cómo y por qué ocurren, podemos tomar medidas para prevenirlas. Recuerda que la clave está en ser un usuario crítico y verificar siempre la información generada por ChatGPT.

Sección de preguntas frecuentes (FAQs)

1. ¿Qué tipos de alucinaciones existen en ChatGPT? Existen diferentes tipos de alucinaciones en ChatGPT, que varían según la naturaleza de la información incorrecta o inventada. Algunas de las más comunes incluyen:

- Alucinaciones fácticas: El modelo inventa información que es directamente contradictoria con la realidad. Por ejemplo, podría afirmar que un evento histórico ocurrió en una fecha incorrecta o que una persona famosa realizó una acción que nunca llevó a cabo.

- Alucinaciones contextuales: El modelo genera información que no encaja con el contexto del prompt o de la conversación. Por ejemplo, podría responder a una pregunta sobre un tema específico con información irrelevante o fuera de lugar.

- Alucinaciones lingüísticas: El modelo crea palabras o frases que no existen o que no tienen sentido. Esto puede ocurrir especialmente cuando se le pide al modelo que genere texto creativo o que explore temas poco comunes.

2. ¿Cómo puedo identificar una alucinación en ChatGPT? Identificar una alucinación en ChatGPT puede ser un desafío, ya que el modelo genera información con gran confianza y coherencia. Sin embargo, existen algunas señales de alerta que pueden indicar que una respuesta contiene información falsa o inventada:

- Información sorprendente o inesperada: Si la respuesta te parece demasiado sorprendente o inesperada, es una buena idea verificarla en fuentes confiables.

- Falta de fuentes: Si ChatGPT no puede citar fuentes para respaldar su información, es una señal de que podría estar «alucinando».

- Contradicciones: Si la respuesta contradice información que ya conoces o que has encontrado en otras fuentes, es probable que sea una alucinación.

- Lenguaje vago o general: Si la respuesta utiliza un lenguaje vago o general, sin detalles específicos, podría ser una señal de que el modelo está «rellenando huecos» con información inventada.

3. ¿Qué herramientas puedo utilizar para verificar la información generada por ChatGPT? Existen diversas herramientas y recursos que puedes utilizar para verificar la información generada por ChatGPT:

- Buscadores: Utiliza buscadores como Google o Bing para buscar información sobre el tema en cuestión.

- Enciclopedias en línea: Consulta enciclopedias en línea como Wikipedia para obtener información general sobre el tema.

- Bases de datos académicas: Si necesitas información más especializada, consulta bases de datos académicas como JSTOR o PubMed.

- Sitios web oficiales: Verifica la información en sitios web oficiales de organizaciones, instituciones o expertos en el tema.

4. ¿Qué están haciendo los investigadores para reducir las alucinaciones en los modelos de lenguaje? Los investigadores están trabajando en diversas técnicas para reducir las alucinaciones en los modelos de lenguaje. Algunas de las áreas de investigación más activas incluyen:

- Mejora de la calidad de los datos de entrenamiento: Se están utilizando conjuntos de datos más grandes y diversos para entrenar a los modelos, lo que puede ayudar a reducir la probabilidad de que «inventen» información.

- Incorporación de conocimiento del mundo real: Se están desarrollando métodos para integrar conocimiento del mundo real en los modelos de lenguaje, lo que les permitiría verificar la información que generan.

- Detección de alucinaciones: Se están investigando técnicas para que los modelos de lenguaje sean capaces de detectar sus propias alucinaciones y evitar generar información falsa.

5. ¿Cómo afectan las alucinaciones a la confianza en la IA? Las alucinaciones pueden afectar negativamente la confianza en la IA, ya que demuestran que los modelos de lenguaje no son perfectos y pueden generar información incorrecta o engañosa. Es importante ser consciente de las limitaciones de la IA y utilizarla de manera responsable. A medida que los investigadores avanzan en la reducción de las alucinaciones, es probable que la confianza en la IA aumente.